Apple 今日宣布將在 iOS 15 和 iPadOS 15 加入三個全新保護兒童安全的措施,包含 iMessage 安全功能、iCloud 照片中兒童性侵犯內容(CSAM)的增強檢測,以及 Siri 和搜尋的更新。

Apple 兒童 安全保護措施 – iMessage

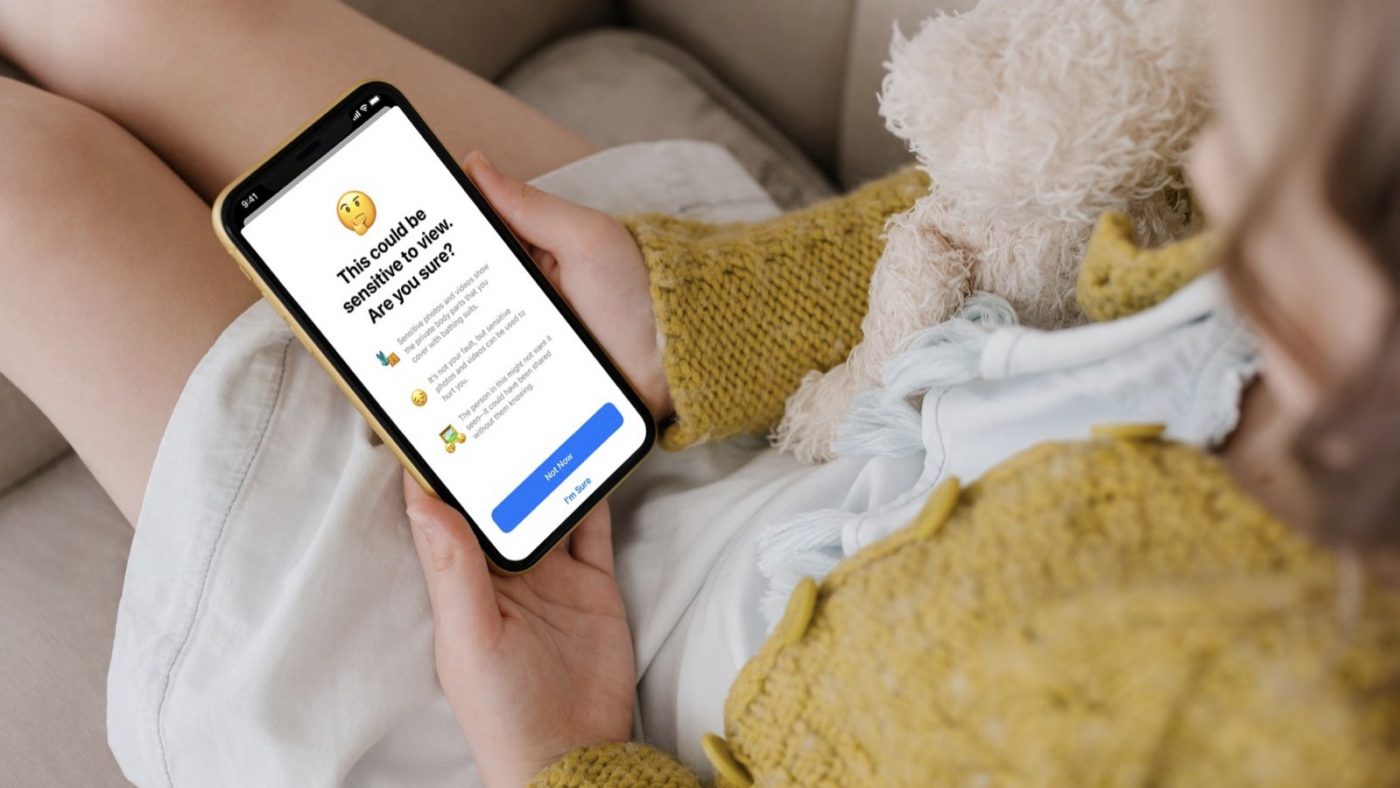

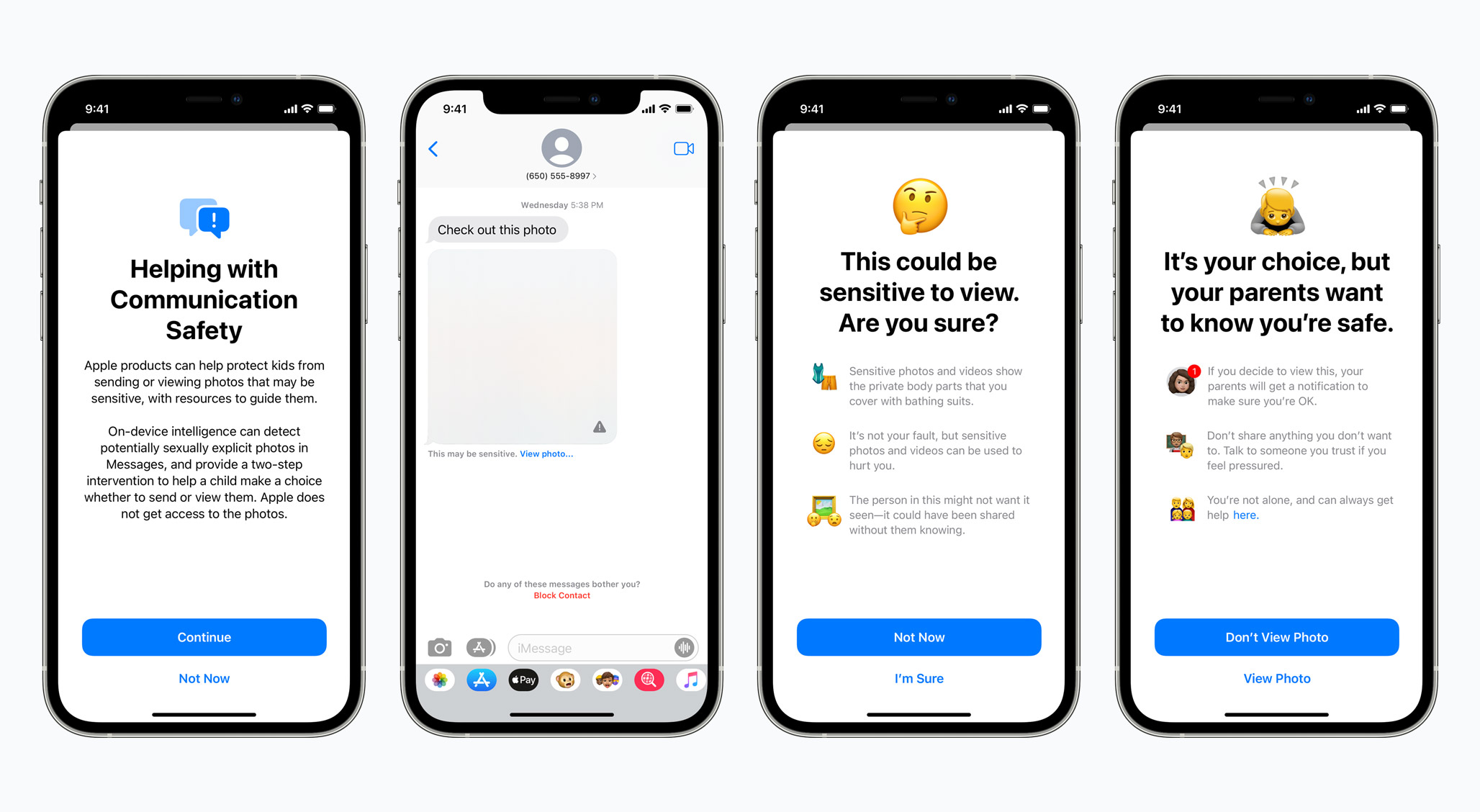

其中一個全新安全措施,在提高兒童使用 Apple iMessage 時的安全性,就是當孩子和父母接收或發送色情照片時,iMessage App 現在會向他們顯示警告。

如果 17 歲以下的兒童收到這類色情內容時,照片直接會被模糊處理,如果孩子點擊「查看照片」,他們會看到一條彈出訊息,告知他們為什麼該照片內容被認為是敏感的,如果孩子決定還是要查看照片,他們的 iCloud Family 父母將收到訊息通知,以確保孩子沒事。

若孩子試圖發送露骨的色情照片,孩子也會知道,如果他選擇發送,他的父母也會收到通知。

這功能,是透過機器學習來分析訊息裡的附件圖像是否有包含色情內容,以達保護兒童安全,Apple 也表示,iMessage 保持點到點加密設計,Apple 無法訪問任何消息內容的權限。預計在今年九月後,美國更新推出,適用 在 iOS 15、iPadOS 15 和 macOS Monterey 的 iCloud 中設置為家庭的帳戶。

Apple 兒童 安全保護措施 – 兒童性侵犯內容 CSAM 檢測

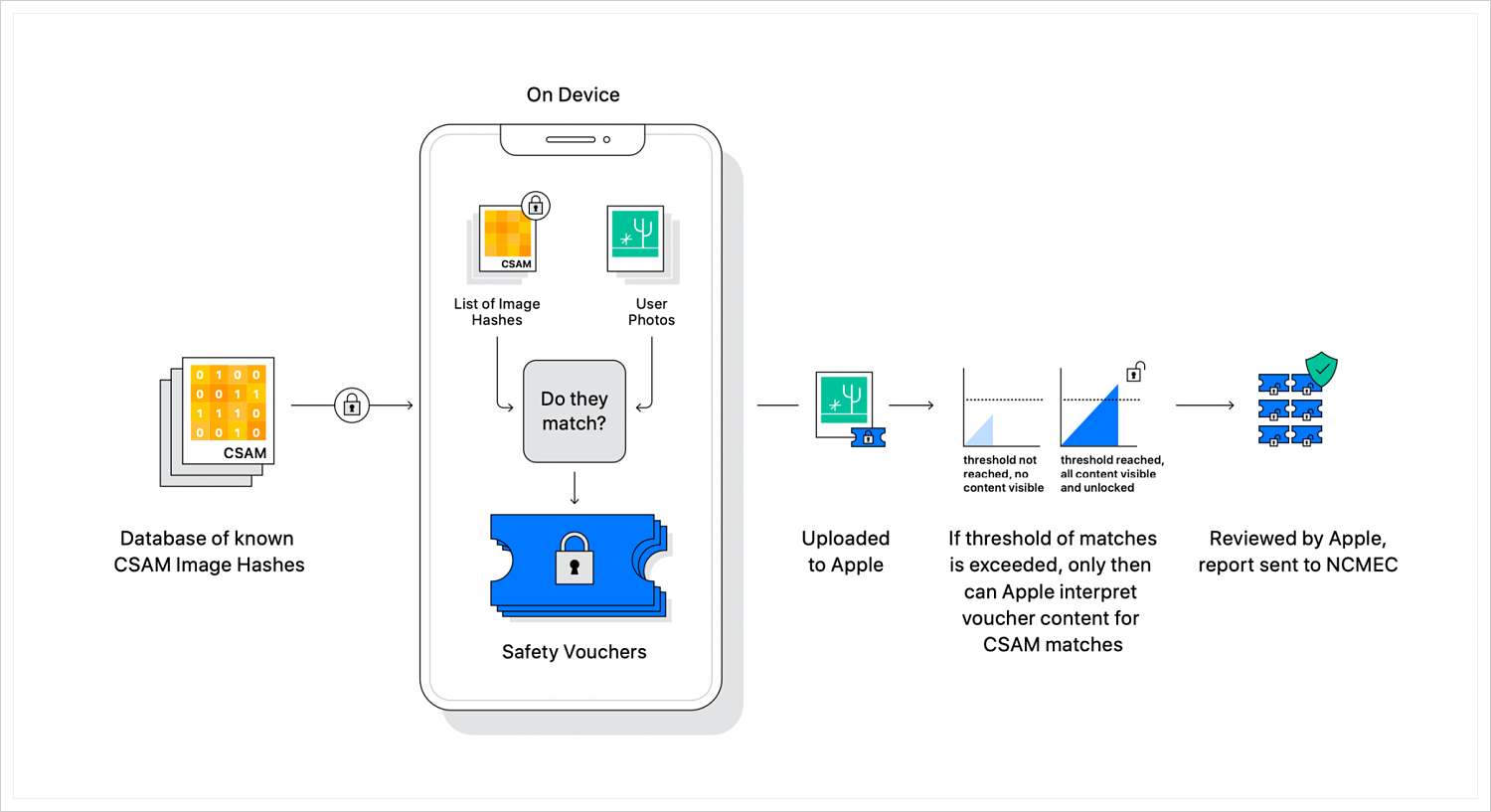

另一個 Apple 兒童 安全保護措施,就是針對 iCloud 照片中的兒童性侵犯內容( CSAM, Child Sexual Abuse Material )檢測。 CSAM 是指涉及兒童虐待、性侵等活動的內容,Apple 為了幫助解決這個問題,將在 iOS 和 iPadOS 中推出新的 hashing 技術,允許 Apple 檢測儲存在 iCloud 照片中的已知 CSAM 圖像。

若有檢測到照片,Apple 可以向國家失踪和受虐兒童中心(NCMEC)報告 CSAM 實例,這個兒童中心是 CSAM 的綜合報告機構,並與執法部門密切合作。

iCloud 照片檢測,運作方式?

Apple 的新技術是將使用一種名為「雜湊 hashing」,一種資料儲存與擷取的技術。Apple 檢測設計絕對有考慮使用者的個人隱私,所以這個檢測系統不是在雲端掃描圖像,而是使用國家失踪和受虐兒童中心(NCMEC)提供的已知 CSAM 圖像在 hashing 資料庫上進行匹配後,Apple 將此資料庫轉換為一組不可讀的 hashing 值,並安全地儲存在使用者的設備上。

所以,Apple 系統檢測方式,僅審查與已知 CSAM 圖像內容匹配的圖片,並回報這些資訊給資料庫。如果你是幫孩子洗澡的照片,因為這些圖片與 NCMEC 資料庫不符,所以並不會有異常出現。

當 Apple 在某個 iCloud 帳號檢測到「CSAM 匹配」的照片次數超過異常門檻,加密技術就會通知並允許 Apple 解密去查看異常照片的帳號,隨後以人工審查照片是否為兒童性侵犯內容,並在如有必要時向 NCMEC 發送報告或通知執法部門。

CSAM 圖像檢測功能不是一個自行選擇要不要開啟的功能,它是會自動發生的,但有心犯罪的人,如果關閉 iCloud 照片服務,它將無法檢測到已知的 CSAM 圖像。目前 Apple 也會先在美國推出這功能,最終希望能推廣到更多地方。

Apple 兒童 安全保護措施 – Siri 語音助理 和 Search 搜尋

最後,Apple 也對 Siri 和 Search 進行升級,幫助兒童和父母保持線上的安全環境。例如,詢問 Siri 如何報告 CSAM 或兒童虐待的使用者,將被指向如何提交報告的相關資源。

目前,Apple 仍在更新 Siri 和 Search,未來只有要使用者透過 Siri 或 Search 查詢相關兒童性侵犯內容,都會有干預性的措施,讓使用者了解這主題是有害和有問題的。

這些新功能的更新,預計也會在今年九月後 iOS 15、iPadOS 15、watchOS 8 和 macOS Monterey 的更新中推出。

三個 Apple 兒童 安全保護措施

三大新功能的推出,對於長期在推動如何保護兒童安全,以及避免兒童性侵犯內容散播的相關人士,絕對是持正面看待。

但在 iCloud 照片檢測功能上,的確就有一些安全研究人員擔心,這項技術是不是可能會被利用來識別其他類型的圖片,比如政治抗議的照片等,甚至使用者個人隱私權的疑慮。

Apple 明確表示,這功能只會用在 CSAM 圖像的檢測,並正在向密碼學專家展示這個系統,以證明它可以在不損害使用者隱私的情況下檢測非法的兒童性虐待圖片。

如果想第一時間看到更多 Apple 相關資訊,請追蹤蘋果迷粉絲團以掌握最新訊息,並且訂閱我們 YouTube 頻道,取得直播第一時間通知,或者加入蘋果迷社團跟大家一起討論使用心得哦~

如果想要與蘋果迷近距離聊天,可以加入我們的 YouTube 頻道會員,前往會員專屬的 Discord 聊天室找我們。