每年 Google I/O 都是科技圈的大日子,今年當然也不例外。今年的 Google I/O 活動已於美國時間 5 月 20 日早上 10 點(台灣時間 5 月 21 日凌晨 1 點)在加州山景城的 Shoreline Amphitheatre 正式登場。這場發表會依舊以開發者為主軸,但同時也對消費者釋出大量 AI 相關更新,重點非常明確:人工智慧無所不在,從搜尋到穿戴裝置,甚至連你拍影片的方式都變了!這篇文章會幫你完整整理 Google I/O 2025 懶人包 最重要的五大亮點,讓你快速掌握 Google 今年的野心與未來方向。

Google I/O 2025 懶人包 五大重點一次看

Google I/O 2025 已於美國時間 5 月 20 日上午 10 點(台灣時間 5 月 21 日凌晨 1 點)在加州山景城的 Shoreline Amphitheatre 正式登場,並透過 Google 官方網站和 YouTube 頻道進行直播。本次大會的主題明確聚焦於人工智慧(AI),涵蓋 Gemini 模型、Android XR 智慧眼鏡、AI 搜尋體驗等多項創新。

以下為重點整理:

Gemini 2.5:AI 不只更聰明,也更貼近你的日常

Google 在這次 I/O 宣布持續精進、強化主力模型 Gemini 2.5 Flash,另外也讓 Gemini 2.5 Pro 將搭載「深度思考」(Deep Think)模式,這是一種強化推理能力的技術,能讓 AI 進行多步推理與更複雜的任務規劃。例如,幫你計畫旅行不只是查景點,而是依據行程、預算、自身資料去做出客製化建議。

這個版本也支援更長的上下文理解,在處理長篇文件或複雜任務時表現更加穩定。開發者方面也能透過 Gemini API 使用這些能力建構應用。

此外 Google 也在 I/O 更明確展示 Gemini 模型已全面整合進 Gmail、Chrome、Google 搜尋與 Gemini App 等日常工具中,不過仍屬測試階段。

在 Gmail 中,Gemini 即將於今年夏季推出「個人化智慧回覆」功能。它能根據你的寫作風格、歷史內容,幫你撰寫風格貼近的回信,像是根據舊郵件與 Google 文件自動整理旅行經驗,生成自然、具體的回覆內容。

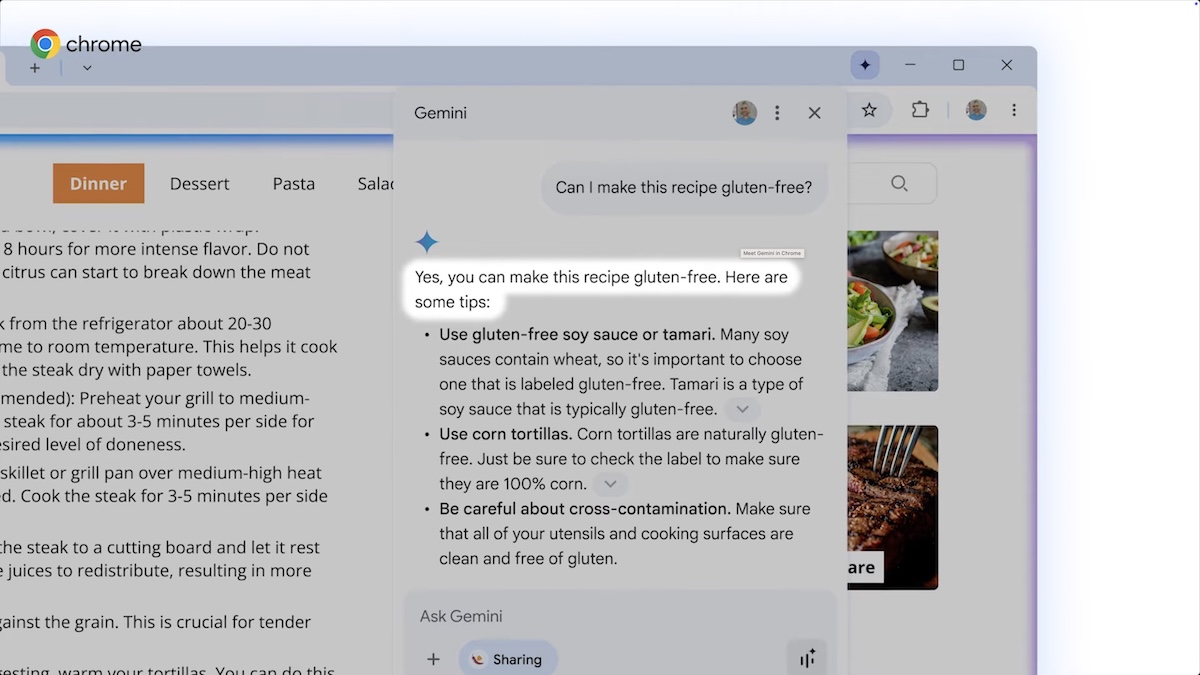

Google 也首次將 Gemini 整合進 Chrome 瀏覽器的測試版,提供情境式協助。像是你閱讀網頁時,它能自動提供摘要、協助起草回覆、甚至產生程式碼,強化日常瀏覽體驗。

AI Mode:Google 搜尋邁向「對話式理解」的新階段

傳統的搜尋是一問一答,AI Mode 則是轉向更深入的對話與探索方式。你可以問更長、更多層次的問題,AI 回應也會結合多個來源、自動彙整資訊,像是一個有邏輯的助理而不只是單純連結的聚合器。

AI Mode 也引入了全新的 Deep Research 模式,支援數百項查詢同時處理,幾分鐘內幫你彙整研究報告草稿,適合做報告、寫作、或大量資料彙整時使用。這功能已經整合進 Google 的 Canvas 編輯器。

未來幾個月內,Google 將進一步導入 Search Live(即時搜尋)功能,讓你用相機對準眼前物品,直接詢問 AI,得到視覺搜尋結果。

此外,AI Mode 也將逐步支援個人化情境整合。舉例來說,如果你允許連結 Gmail 和日曆,搜尋時它可以主動考量你的旅遊計畫、過往偏好與用餐記錄,提供貼近你需求的建議。這些功能都會明確標示,並可隨時開啟或關閉。

Android XR 智慧眼鏡:Gemini 助理就在你眼前

Google 在 I/O 2025 更進一步展示了 Gemini 與 XR 技術的結合,它讓 Android XR 智慧眼鏡不只是個裝置,而是一整個生態系的一部分。這些眼鏡內建麥克風、喇叭與相機,可與手機協作,不需要掏出手機就能處理訊息、拍照、找路,甚至進行語音翻譯。

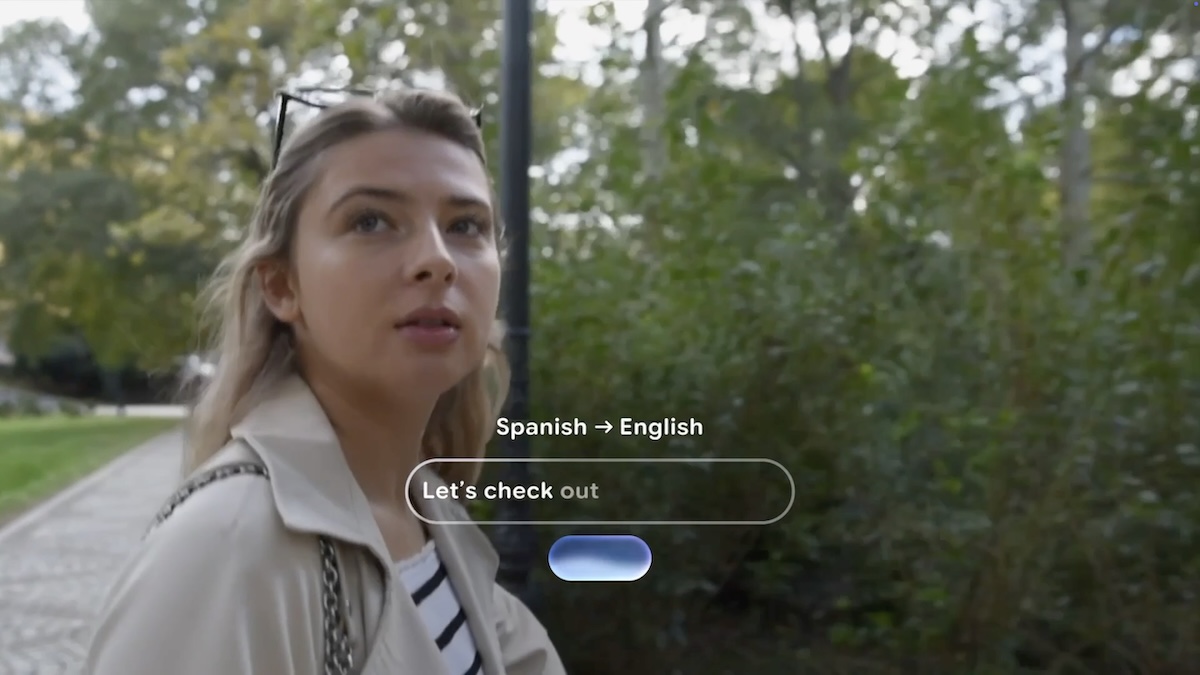

更重要的是,透過與 Gemini 的整合,它可以感知你的視角、理解你當下的情境,並主動提供協助。例如當你與外國朋友交談時,它可以即時翻譯對話內容,讓你戴著眼鏡就像開啟「現實字幕」。

眼鏡的鏡片還可選配內嵌顯示器,在需要的時候顯示資訊,例如導航提示、即時通知,並透過隱私設計避免資訊外洩。

Google 表示這樣的設備不只是科技產品,更要成為「你願意整天配戴的東西」。因此他們與多家時尚品牌合作,包括 Gentle Monster 和 Warby Parker,共同開發具備設計感的 XR 眼鏡款式。

除此之外,Google 也持續與三星合作,拓展 Android XR 至頭戴式顯示器領域。像是先前展示過的 Project Moohan,將在今年稍晚登場,帶來沉浸式的虛實整合體驗。Google 並宣布將推出 XR 軟硬體參考平台,供開發者打造專屬應用,預計今年內陸續釋出。

目前這些設備仍處於原型階段,但 Google 已經開始與信任的測試者群組合作,收集使用回饋,並預告在未來幾個月會有更多發展消息。

AI 購物新體驗:從靈感、試穿到結帳都更智慧

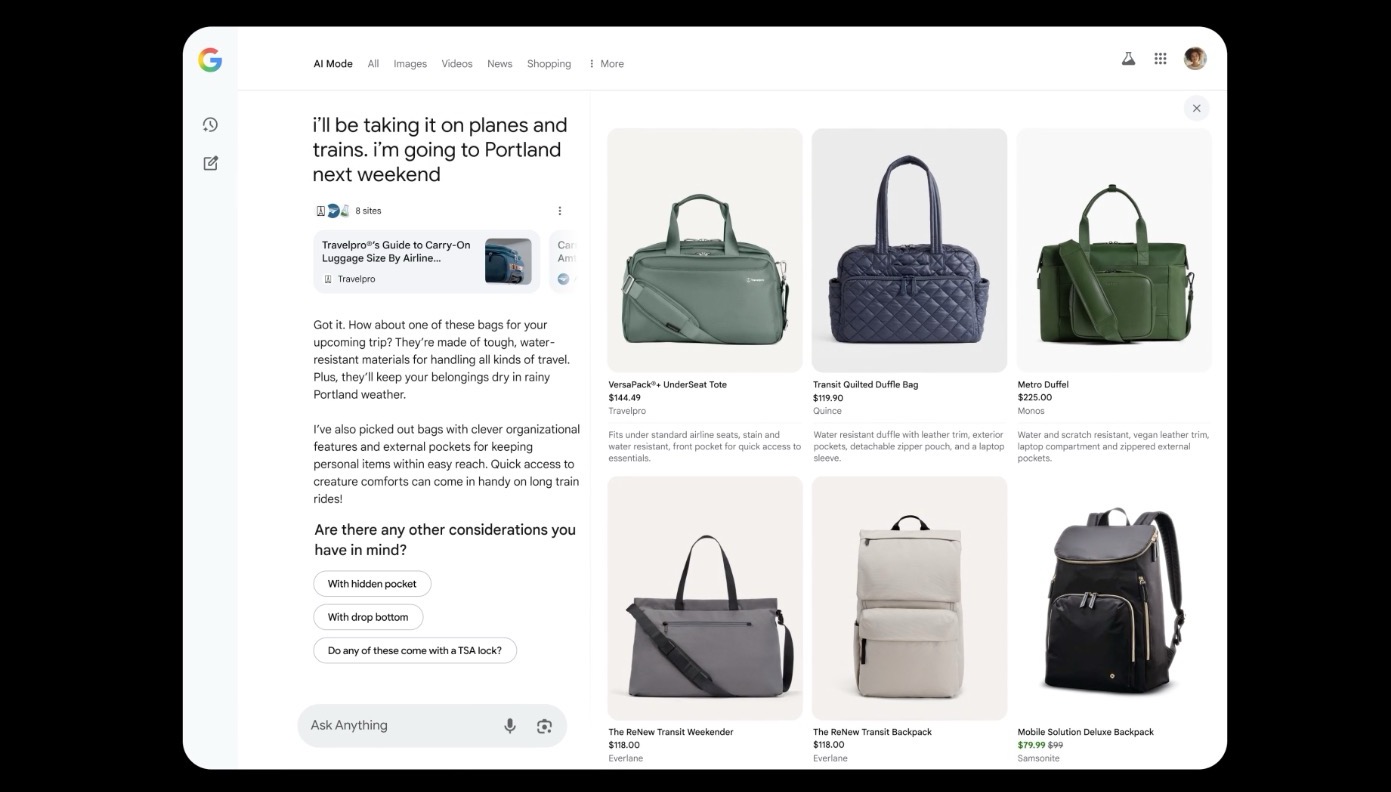

今年 Google I/O 2025 中,AI 模式在購物體驗上帶來顯著改變,讓整個流程從「靈感搜尋」到「實際購買」都更直覺、個人化。Google 將 Gemini 模型與「購物圖譜」(Shopping Graph)整合,提供超過 500 億筆即時商品資訊,包括價格、評論、庫存等,協助你精準找到符合需求的產品。

你只要輸入像是「適合五月去波特蘭的旅行包」,AI 會透過查詢擴展技術,自動分析天氣、使用情境與款式建議,並同步在畫面顯示推薦商品,幫你快速縮小選擇。

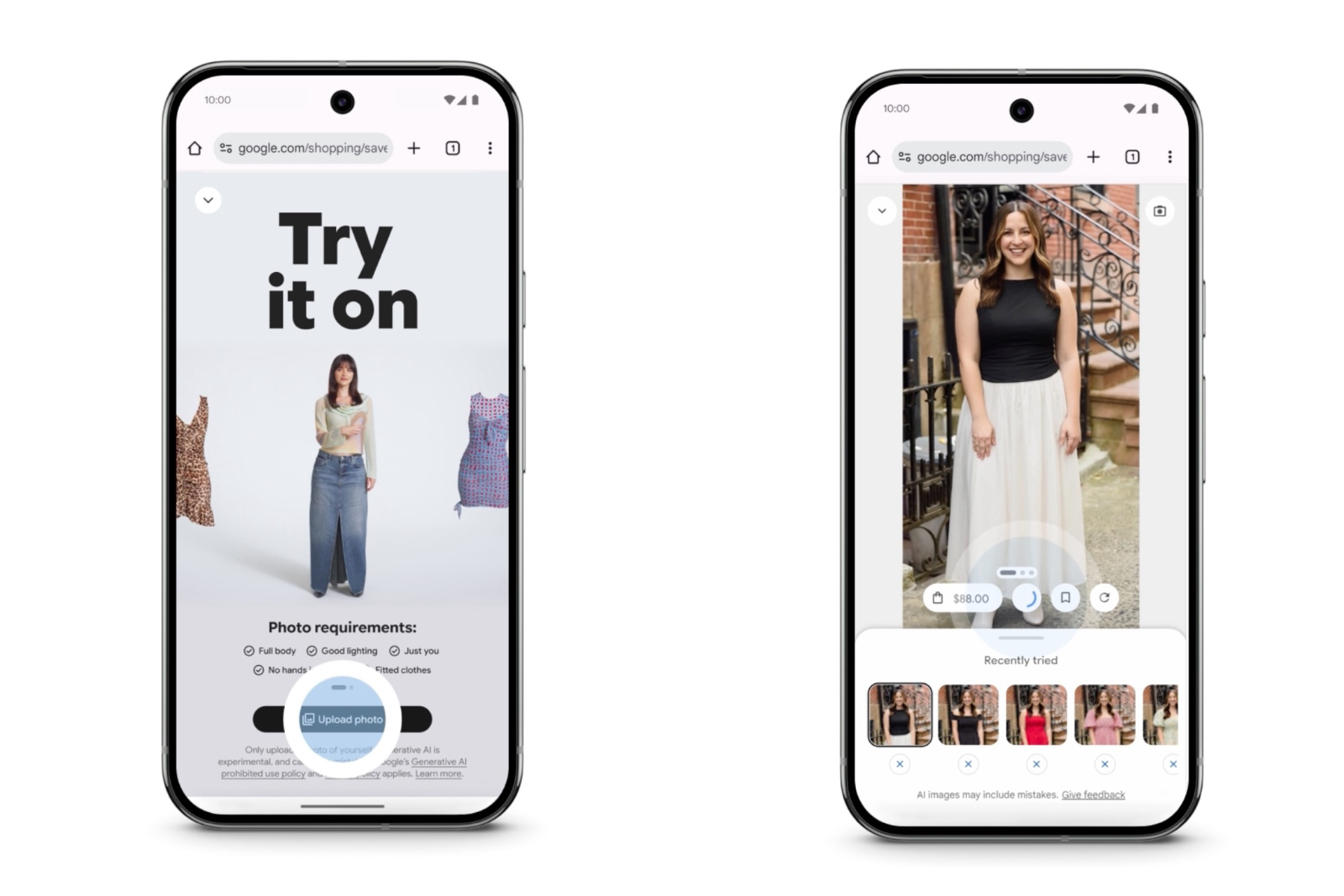

同時推出的虛擬試穿功能,讓你上傳照片就能模擬衣服穿在自己身上的樣子,系統能精準呈現布料材質與摺痕效果,帶來真實的視覺參考。

最後是代理結帳體驗:只要啟用價格追蹤,當商品價格落在你設定的區間時,系統會通知你,並可透過 Google Pay 自動結帳,節省手動操作時間。

這些功能目前已在美國開始推行,未來將擴大應用範圍,徹底改寫線上購物的方式。

生成式媒體進化:Veo 3、Imagen 4 與 Canvas 提升創作效率

今年 Google I/O 展示了生成式媒體領域的重大進展,讓創作者從影像到影片的製作過程變得更快速、更具彈性。

首先是全新的 Veo 3 影片生成模型,能根據文字指令產出高畫質、具備音效與自然過場的影片片段,適用於教學影片、社群內容或簡報補充。它支援多語言敘述與場景延展,是目前 Google 最成熟的影片生成工具之一。

圖像方面,Google 也推出了 Imagen 4 模型,進一步提升細節還原度與風格一致性,適合用於行銷素材、封面設計與內容插圖。這兩項工具都已與 Gemini 深度整合,使用者可在 Gemini App 或 Canvas 平台上直接操作。

此外,Canvas 現在也支援生成互動式圖表、播客草稿、多語言測驗等內容,特別適合教育、報告與社群創作用途。搭配 Gemini 的 Deep Research 模式,使用者甚至能在資料整理後一鍵生成視覺化素材,顯著節省創作時間。

生成式 AI 已從實驗走向實用,這波工具更新也代表 Google 正積極將內容創作變得更容易被每個人掌握。

總結:從模型進步到真實生活,AI 正在變得實用且自然

Google I/O 2025 最大的改變,不只是展示新技術,而是讓 AI 真正進入人們的日常應用裡。從瀏覽器、信箱到智慧眼鏡,Google 把 Gemini 模型深度整合進每一個使用場景,並強調個人化與實用性。

這不再是你需要去適應的 AI,而是會主動來理解、幫你完成事情的 AI。未來已不再只是模型實驗,而是產品體驗。

- 相關文章:快更新!用 iPhone 也能用 Google 翻譯當預設!

- 相關文章:如何使用 Google 翻譯 網頁版的「 影像翻譯 」 功能?

- 相關文章:Google 地圖 20 週年特別整理:這些好用功能絕對不能錯過!

Google I/O 2025

如果想第一時間看到更多 Apple 相關資訊,請追蹤蘋果迷粉絲團以掌握最新訊息,並且訂閱我們 YouTube 頻道,取得直播第一時間通知,或者加入蘋果迷社團跟大家一起討論使用心得哦~

如果想要與蘋果迷近距離聊天,可以加入我們的 YouTube 頻道會員,前往會員專屬的 Discord 聊天室找我們。